既にバズワードとしての賞味期限は切れた気がしますけどねw

しかしながら、なくなったというわけではなく、むしろ重要性は増してきているように感じます。というのも、その先のAIがクローズアップされているからです。AIのディープラーニングにはビッグデータが不可欠で、有機的に結びついている様が伺えます。

さて、そんなビッグデータですので、一番先に書く内容に相応しいかと思って再確認も含めてまとめてみましょう。

ちなみに、IT関連テーマそれぞれの位置づけは以下の記事をご参照ください。

目次(クリックで飛びます)

ビッグデータ(Big data)とは?

明確な定義はありませんが、言葉そのままを捉えるなら「大量のデータ」です。が、一応もう少し踏み込んで、ビッグデータの特徴を捉えた3Vなるものがあります。

- Volume(量):データ量です。トラフィック量も増加します。

- Variety(種類):データの種類も重要です。これまでの整理しやすいデータから、映像などの整理しにくいデータも扱うことになります。

- Velocity(更新頻度):リアルタイム性のことですね。つまり、その場その時の現実をそのままデータ化することです。

また、この定義に「正確さ(veracity)」、「変動性(variability)」、「可視化(visualization)」、「価値(value)」を付け加えて領域拡大したものもあります。基本としては上の3点がビッグデータで実現すべきポイントです。

データ量:情報爆発

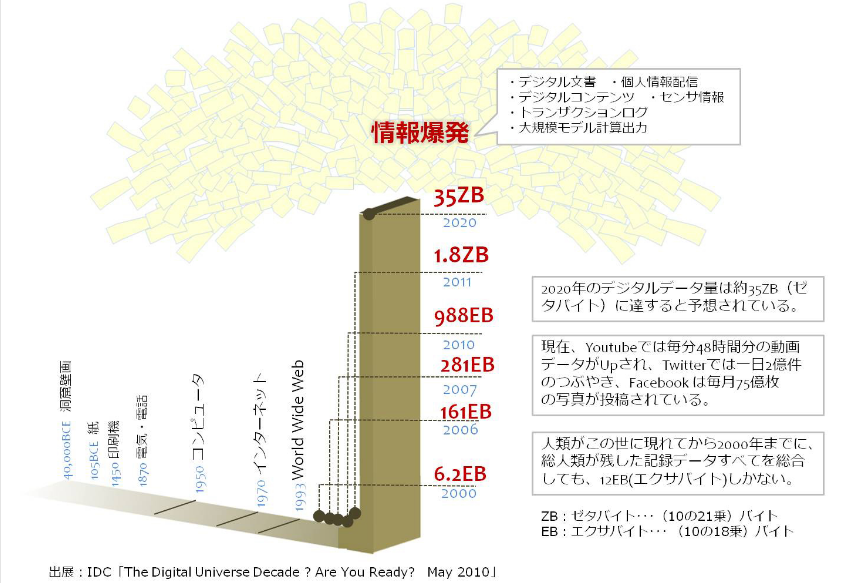

情報爆発=データ量の爆発的増加がトレンドです。具体的にどのくらい凄いかというと……

(出典:IDC)

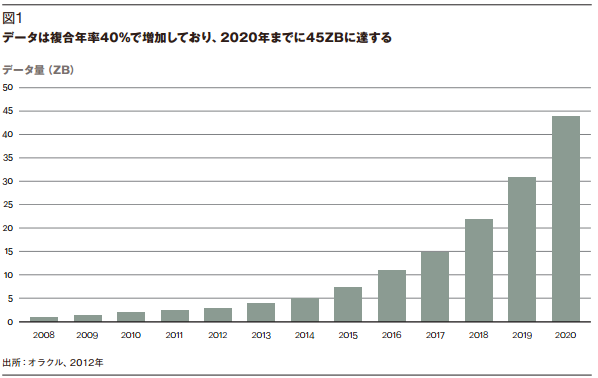

もう一枚、直近で見てみましょう。世界にあるデータ量は1.2年程度で倍増する勢いで増加しており、世界のデータの90%が過去2年間のみで作成された計算になるそうです。

(出典:Oracle)

広義ではインターネット、近年はSNSやYoutubeといった個人メディアが台頭し、双方向の情報通信を生みました。今後はIoTによってさらに大量のデータが収集されると想定されています。集めたデータの活用方法は別途見ていきます。

ちなみに……人間の脳は3TB程度だそうですよ(ムダ知識)。

データの種類:非構造化データ

非構造化データ:NoSQLと言うそうです。

これまでデータというと、加工の簡単なテキストのデータベース中心でした。ところが、現在は映像・音声データをはじめとした、数値化・言語化出来ないデータもたくさん入ってきています。データの入力装置としては人以外にモノ(IoTセンサー)等も加わり、データの種類は、「現実を表現出来るだけのデータ」という上限まで増えていくのです。

当然データの組み合わせも膨大、しかも以前よりデータフォーマットが統一されておらず、解析しにくくなったおまけつきです。

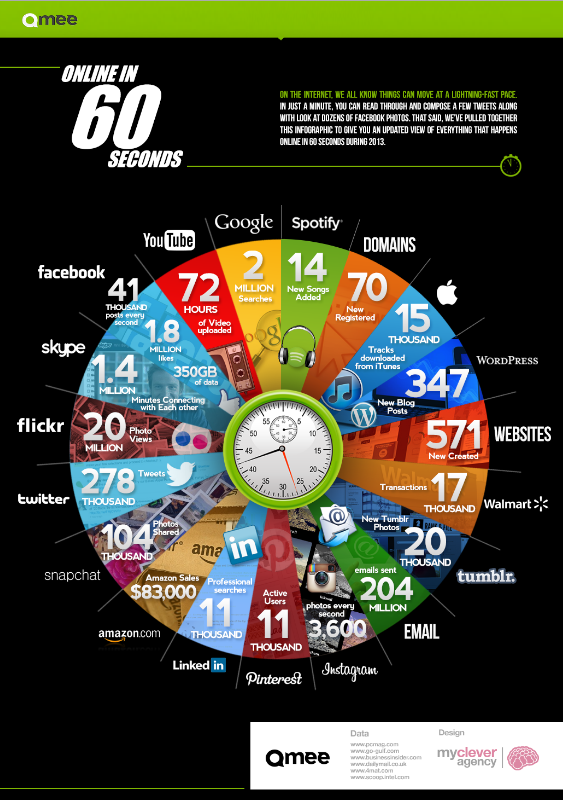

以下の図は60秒間に発生する世界中のオンライン活動を示したものです。ちっちゃく書かれている桁数がおかしいw

(出典:Qmee)

更新頻度:リアルタイム性

ビッグデータとはデータ量が多いばかりではなく、それらがリアルタイムに情報として入ってくる必要があります。上で見たように、リアルタイムの情報を得ることが、「ありのままの現実を知る」ことに繋がるためです。

注意しないといけないのが、ビッグデータとは「過去か、最高でも現在まで」しかデータを取ることが出来ない点です。当たり前の話ですが、ビッグデータとは未来の情報は一切含まないものです。

そして、投資家なら何度も耳にした言葉だと思いますが、過去の情報が未来について確実な解答を用意してくれることはありません。十分なサンプルがあって、過去のデータが明らかな統計的有意性を示しているときに、はじめて勝負が出来るのです(ブラック・スワン=ドローダウンのリスク、第三の因子といった要素は、どれだけ過去のデータを集めても予測出来ません)。

ビッグデータ否定派……統計学との不整合

ビッグデータを持ち上げる前に、一回否定しておきましょう。先に結論を書くと、ビッグデータとはそのものに価値があるのではなく、可能性の広がりという点において価値があるのです。

問題点はふたつあります。

※私の勝手な解釈が多分に含まれます。

だって統計学=母集団の代表性でしょ?

例えば日本人の平均身長を測ろうとするとき、統計学がなかった時代は全員の身長を測ろうとしました(当然無理)。

統計学が生まれたことで、母集団の一部の身長を測れば全体に近似すると言えるようになりました(母集団からサンプルを「ランダムに」一定数抽出することで、母集団と構成の似た集団=標本が、母集団を代表すると言える)。

そして今、日本人の平均身長を測ろうとしたら、全員の身長を測って記録していけばいいのです。つまるところ時代に逆行しているわけです。

確かに全員のデータが取れるならそのほうが確実ですし、ビッグデータ時代では可能なことです(書いてから思ったけど視聴率とか視聴時間のほうが事例としては適切だったかもw)。しかし……

統計学の精度

もちろん統計学によって算出された数字は現実のものと完全に一致しないのですが、正規分布に従うモデルであれば平均+-標準偏差内に95%の確率で収まる程度の精度はあります(95%信頼区間とか言いますが、面倒なので95%で当たると思っていいです)。

かなり高い精度だと思いませんか?

統計学というのは、出来るだけ少ないデータで母集団を正確に表現するための方法論ですので、まあ当然なんですが。

そもそも、統計学を出さずとも、全データの取得が困難な時代に、人々は似たことをやってきています。これまでの経験を元に仮説を立て、仕組みを想定して、検証するということを繰り返してきました。ビッグデータというのは、この仮説検証作業を省くだけのものなのです。

さて、今回のビッグデータについての問題点その一はここにあります。統計学で十分ではないかということですね。

ビッグデータの価値

例えば仮説が人の常識から抜け出せない発想であれば、ビッグデータによって異なる結果が出て来る場合があるはずです。この場合にビッグデータに価値があったと言えるでしょうか。

いいえ、結局ビッグデータを集めた後に分析しなければならず、分析に仮説が必要なのです。つまり、仮設を立てるポイントが事前から事後に移っただけです(今までは全てのデータが取れないという制約があったため、先に確度の高いポイントに仮設を立てた)。

そして実際にデータ分析技術については、未だに「統計学」を使います。これではボトルネックが収集量から解析量に移っただけで、全体のアウトプットは変わりません。ここが問題点そのニです。

こういった記事も出ていました。

「本来、統計分析の学問というのは、いかに少ないサンプリング数で全体を捉えるか、を追究したものである。テレビの視聴率調査がいい例で、わずかなサンプリング数で日本全国の状況を把握できている。目的さえ明確であれば、必ずしも大量のデータはいらない」

その通りですね。実際、ビッグデータによって得られたのは、分かりきったことを確認するためのデータだけということも多いです(そして上層部への説明資料の根拠として大変重宝される)。

分析主体が人間からAI(人工知能)へ

ですが、最近の技術革新がビッグデータ分析の問題について、一つ先の段階へと進めました。それが人工知能によるビッグデータ分析という掛け合わせです。

人工知能はインプット量に制限がなく(多ければ多いほどいい)、膨大なデータを元にディープラーニングを行い、推論、認識、判断や表現等を行う知能を自分で獲得することが可能です。

もちろん、既存ベースの考え方では、大部分が統計学によって掘り起こされています。人工知能に期待するのは、人の頭脳ではほぼ不可能なブレイクスルーです。この点において、ビッグデータの価値が生まれ得るのです。

※近年の人工知能は、認識力においては人間を上回ったとも言われています。今後、更なる認識力向上に、コンテクスト(文脈・背景)のより精緻な把握が必須です。

アイデアとは既存の要素の新しい組み合わせ

蛇足ですがw

アイデアの発想で、よくこんなことを言いますよね。前に小説記事で発想法について書きました。

要素(データ)の数が多いということは、この思考のスパークを引き起こしやすくなると言えるでしょうか?

まあ必ずしもインプットの量がアウトプットを決めるわけではありませんが、インプットが多ければ多いほど豊かな発想に繋がることも事実です。

残念なのは、舞い降りてきた発想が目的の内容であることは稀で、大半は全く無関係な方向に発展していくことです。

ビッグデータ分析、AI(人工知能)が進展したら、投資家はどうなるのか

やっぱりビッグデータになろうが投資に絶対はないですよ。株価は既にチャートでリアルタイムに把握出来るわけですし、膨大なデータがあっても新しい(怪しげな)相関を手に入れるだけです。こねくり回したような相関関係にはカーブフィッティングの問題も残りますし、ブラック・スワンのリスクはどうしたって消せません。

あるいは、ビッグデータが行きつくところまで行って、現在の世界を文字通り全て把握出来るようになったとしても同じことです。原因と結果が再帰性を持つ世界であり、べき乗則の世界ですので、現在を把握したことが次の一秒を把握したことにはなりません。バタフライ効果ってやつです。

他のIT系テーマについて以下でまとめております。よろしければ合わせてお読みいただけるとうれしいです。